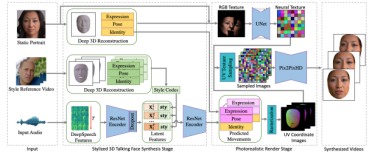

清华大学教授、智源青年科学家贾珈团队针对多模态个性化人机交互方式,创新性地提出了基于风格模仿的音频驱动唇形合成方法,给定任意一段源唇形序列,一段驱动语音,即可合成和语音同步,并且和源唇形序列风格相符的目标唇形序列。为了实现风格模仿,该方法从源唇形序列中抽取了风格统计参数,并将统计参数融入到音频-唇形预测网络中,实现风格化的唇形预测。该方法不需要任何风格上的标注,音频-唇形预测网络完全是以自监督的方式进行训练,同时,对于训练好的模型,该方法可以模仿任意源序列的风格。将合成的唇形序列与神经渲染器结合,合成真实感视频。实验显示,合成的视频在风格表现力、面部动作的自然程度上均取得了显著的提升。

音频驱动的多风格唇型合成与真实感脸像合成(图片来源:学者提供)