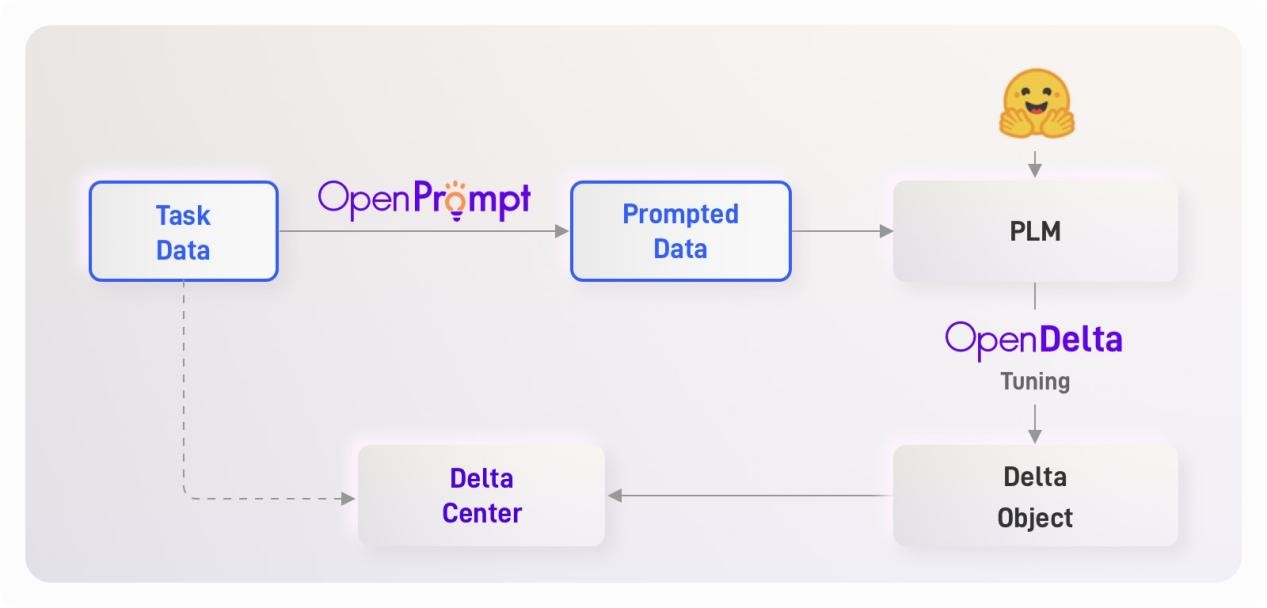

预训练模型已经为了多个领域的基础设施,随着预训练模型参数量的增长,其适配的存储和计算成本也十分昂贵。因此,如何高效地驱动大规模预训练模型成为了值得研究的课题。本研究由北京智源人工智能研究院和清华大学共同开展,在已有的参数高效方法的基础上发展了统一范式的框架和方法:Delta Tuning,即仅需要调整极少量的参数和保持绝大部分参数不变的情况下,就可以取得和全参数微调相当的效果。此框架将参数高效的微调方法进行了统一的数学建模,并且从优化和最优控制两个角度进行理论推导和解释。同时,本研究在逾100个NLP任务上进行了全面的实验分析,分别从表现、收敛性、迁移性、计算效率、缩放性、组合性等多个方面进行了系统性的实验研究,取得了参数高效微调的前沿实验结论。为了促进模型高效微调的相关研究,北京智源人工智能研究院和清华大学研发了模型高效微调的开源工具OpenPrompt和OpenDelta,前者侧重于使用提示学习的范式组织训练流程,后者负责模型的具体参数高效优化,二者协同形成了完整的模型高效微调的工具体系,并同时兼顾了效率和效果,可以在各类预训练模型和下游任务上便捷地完成适配。OpenPrompt和OpenDelta高效微调工具体系已经在GitHub收获1800星标,并获得了ACL最佳系统论文奖,得到了业内的广泛认可。