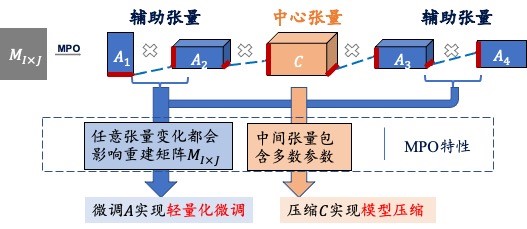

预训练语言模型在多个下游任务获得了非常好的效果,显示出来了巨大潜力,“预训练+微调”的框架已经成为解决下游任务的标准处理流程。然而,大模型中的参数数量巨大,现有的微调方法需要更新所有参数,需要非常大的计算成本。因此,为了在有限资源的设备上使用大模型解决下游任务,我们提出了一种基于矩阵乘积算符(MPO)的方法,可以同时实现模型参数的压缩和下游任务的轻量化微调。在量子多体问题的场景中,MPO可以看做是一种特殊形式的高阶奇异值分解(HOSVD)方法,利用矩阵的特征值大小来表示信息的重要程度,因此可以通过去除权重矩阵中不重要的噪音来实现模型压缩。同时,MPO所得到的张量之间具有非常强的相关性,可以只更新很少的参数就可以达到全局优化的效果,进而实现轻量化微调。我们针对Wenlan模型实现了这个方法,在下游任务的微调中,仅需要33%可训练的参数即可实现近似的效果,如果允许一定的精度损失,模型总大小可以压缩到原总参数量的77%。 并且这种针对矩阵的压缩和轻量化微调的解决方案,可以对已经压缩过的模型进行二次压缩,具有很强的通用性。