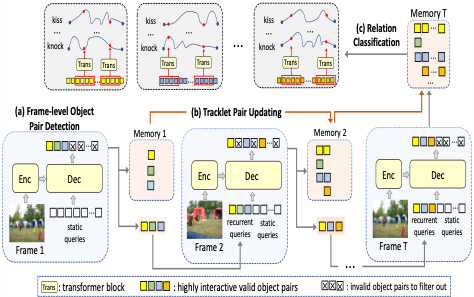

我们通常用<主体,动作,客体>这种三元组的形式来表示日常生活中物体对之间的关系,比如<人,骑,马>这样的动作,由此产生了“视频关系检测”这样一个视觉任务,它要求模型检测出一个视频里每一对关系所属物体和动作类别,以及它在时间和空间上的位置(用检测框轨迹来表示)。传统的视频关系检测工作遵循着一种多阶段的系统框架,不仅难以捕捉视频里长距离的时空场景信息,而且在效率上也不尽如人意。本研究认为在视频关系检测中,上下文的信息很重要,并且不同的模块其实应该是彼此相关的,而一个统一模型不仅能够在端到端的检测过程中利用到这些上下文的信息,同时还能够基于多任务学习的训练目标同时优化不同的模块使其互相促进。因此,我们提出了一种基于transformer的VRDFormer框架。VRDFormer由视频编码模块和基于查询的关系实例生成模块组成。视频编码模块将视频编码为帧级别的特征。基于query的关系实例生成模块则逐帧处理编码后的特征,并以自回归方式生成关系实例。它由三个子模块组成:1)帧级目标对检测;2)轨迹对更新;以及3)关系分类。首先,我们的模型使用static query来检测每一帧中的所有对象对。然后,我们选择一些具有高置信度的候选对,称为recurret query,将它们输入到下一帧中,从而在时空上下文中高效地跟踪对象对。在自回归过程中,我们将每个帧的预测保留到一个存储模块中,然后使用关系预测模块来预测对象对的关系类别。该模型与目标对检测和关系分类联合训练。在两个基准数据集ImageNet VidVRD和VidOR上的大量实验证明了所提出的VRDFormer的有效性,它在关系检测和关系标记任务上都达到了最先进的性能。