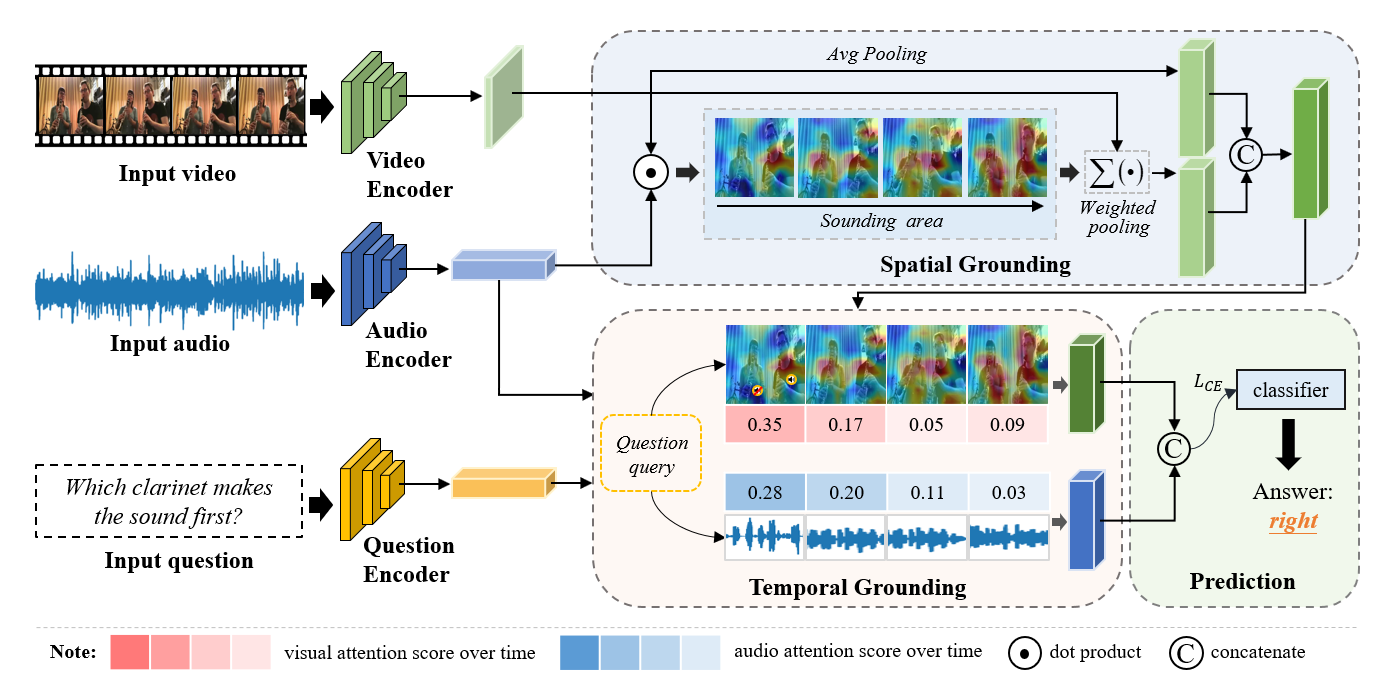

我们在日常生活中被视觉和声音信息所包围,这两种信息的结合利用提高了我们对场景的感知和理解能力。想象一下,当我们身处在一场音乐会中时,同时观看乐器演奏动作和聆听音乐的旋律可以很好地帮我们享受演出。受此启发,如何让机器整合多模态信息,尤其是视觉和声音等自然模态,以达到与人类相当的场景感知和理解能力,是一个有趣且有价值的课题。因此,中国人民大学GeWu实验室与罗彻斯特大学(美)研究团队专注于视听问答(Audio-Visual Question Answering, AVQA)任务,旨在回答有关不同视觉对象、声音及其在视频中的关联的问题。显然,必须对视听场景进行全面的多模态理解和时空推理才能做出正确的回答。为了探索视听场景理解和时空推理的问题,研究团队构建了一个专注于问答任务的大规模的视听数据集(Spatial-Temporal Music AVQA,MUSIC-AVQA),其中包含超过45K个问答对,并涵盖了不同模态下的9类问题类型以及33个不同的问题模板。为了解决上述 AVQA 任务,团队分别从空间和时序感知的角度出发,提出了一种动态视音场景下的空间-时序问答模型。具体来说就是首先提出了一个基于注意力机制的声源定位的空间模块来模拟这种跨模态的关联,然后提出了一个基于注意力机制的声源定位的空间模块来模拟这种跨模态的关联,最后再融合上述空间感知和时间感知的视听特征,得到问答的联合表示,以预测视频关联问题的答案。所提出的框架能使AI能够像人一样理解动态视音场景并能做出一些推理。作者团队相信提出的MUSIC-AVQA数据集可以成为评估视听场景细粒度理解和时空推理的基准平台,同时也认为这项工作是探索视听推理的开篇之作,为该领域开创了一个良好的开端,并借此希望能够激励更多的人同我们一道去探索这一领域。