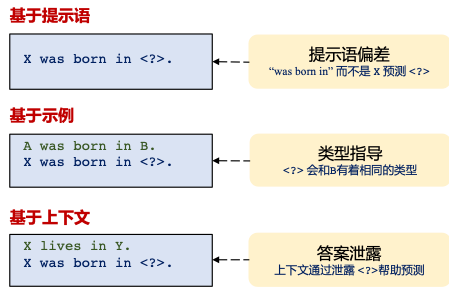

近年来,已有诸多研究将大规模预训练语言模型作为知识来源,并探索从PLMs中抽取事实知识或支撑下游的诸多智能任务。中国科学院软件研究所研究员、智源青年科学家韩先培等人对从PLMs中抽取事实知识的三种代表性范式进行了系统实验分析,发现:(1)对于Prompt-based Retrieval,Prompt会给预测带来严重的偏差;(2)对于Case-based Analogy,加入示范性的样例只能帮助预训练模型更好地识别尾实体的类别,而不能更好地定位事实型知识。(3)对于Context-based Inference,检索得到的上下文会通过显式或者隐式地泄露答案来提供额外信息。韩先培团队揭示了PLMs能够取得知识性能的原因和潜在的预测机制,并且反思了先前预训练模型可作为事实型知识库的结论,该研究可以为PLMs到KG的研究提供结论支撑,并为其它领域的未来研究方向提供参照。

图. 从PLMs中抽取事实知识的三种代表性范式(图片来源:学者提供)